Пакетная обработка – Обработка пакета файлов Photoshop

Пакетная обработка | Microsoft Docs

- Время чтения: 5 мин

В этой статье

Типичный сценарий работы с большими данными — это пакетная обработка неактивных данных.A common big data scenario is batch processing of data at rest. В этом случае исходные данные загружаются в хранилище данных либо самим исходным приложением, либо рабочим процессом оркестрации.In this scenario, the source data is loaded into data storage, either by the source application itself or by an orchestration workflow. Затем данные параллельно обрабатываются на месте с помощью задания, которое также может быть инициировано рабочим процессом оркестрации.The data is then processed in-place by a parallelized job, which can also be initiated by the orchestration workflow. В рамках обработки может выполняться несколько итеративных шагов до того, как преобразованные результаты будут загружены в хранилище аналитических данных для последующего запроса компонентами аналитики и отчетов.The processing may include multiple iterative steps before the transformed results are loaded into an analytical data store, which can be queried by analytics and reporting components.

Например, журналы с веб-сервера могут быть скопированы в папку, а затем обработаны за ночь для формирования ежедневных отчетов о веб-действии.For example, the logs from a web server might be copied to a folder and then processed overnight to generate daily reports of web activity.

Когда следует использовать это решениеWhen to use this solution

Пакетная обработка используется в различных сценариях — от простых преобразований данных до полного конвейера ETL (извлечение, преобразование и загрузка).Batch processing is used in a variety of scenarios, from simple data transformations to a more complete ETL (extract-transform-load) pipeline. В контексте больших данных пакетная обработка может выполняться для очень больших наборов данных, которые вычисляются длительное время.In a big data context, batch processing may operate over very large data sets, where the computation takes significant time. (Например, см. раздел лямбда-архитектура.) Пакетная обработка обычно приводит к дальнейшим интерактивным исследованиям, предоставляет данные, готовые для моделирования, в машинном обучении или записывает данные в хранилище данных, оптимизированное для аналитики и визуализации.(For example, see Lambda architecture.) Batch processing typically leads to further interactive exploration, provides the modeling-ready data for machine learning, or writes the data to a data store that is optimized for analytics and visualization.

Одним из примеров пакетной обработки является преобразование большого набора плоских, полуструктурированных CSV- или JSON-файлов в схематизированный и структурированный формат, который можно запрашивать.One example of batch processing is transforming a large set of flat, semi-structured CSV or JSON files into a schematized and structured format that is ready for further querying. Обычно данные преобразуются из необработанных форматов, используемых для приема (например, CSV), в двоичные форматы, которые более эффективны для запросов, так как хранят данные в формате столбцов и часто предоставляют индексы и встроенную статистику данных.Typically the data is converted from the raw formats used for ingestion (such as CSV) into binary formats that are more performant for querying because they store data in a columnar format, and often provide indexes and inline statistics about the data.

СложностиChallenges

Формат данных и кодирование.Data format and encoding. Некоторые из самых сложных проблем возникают, когда файлы используют непредвиденный формат или кодирование.Some of the most difficult issues to debug happen when files use an unexpected format or encoding. Например, исходные файлы могут использовать сочетание кодировки UTF-16 и UTF-8, содержать непредвиденные разделители (пробел вместо знака табуляции) или символы.For example, source files might use a mix of UTF-16 and UTF-8 encoding, or contain unexpected delimiters (space versus tab), or include unexpected characters. Другим распространенным примером являются текстовые поля, содержащие вкладки, пробелы или запятые, которые интерпретируются как разделители.Another common example is text fields that contain tabs, spaces, or commas that are interpreted as delimiters. Логика загрузки и анализа данных должна быть достаточно гибкой, чтобы обнаруживать и обрабатывать такие проблемы.Data loading and parsing logic must be flexible enough to detect and handle these issues.

Оркестрация временных срезов.Orchestrating time slices. Часто исходные данные помещаются в иерархию папок, которая отображает окна обработки, упорядоченные по годам, месяцам, дням, часам и т. д.Often source data is placed in a folder hierarchy that reflects processing windows, organized by year, month, day, hour, and so on. В некоторых случаях данные могут быть получены позднее.In some cases, data may arrive late. Например, предположим, что веб-сервер выходит из строя, а журналы за 7 марта не попадают в папку для обработки до 9 марта.For example, suppose that a web server fails, and the logs for March 7th don’t end up in the folder for processing until March 9th. Они просто пропускаются, так как получены слишком поздно?Are they just ignored because they’re too late? Может ли подчиненная логика обработки обрабатывать записи, полученные в неправильном порядке?Can the downstream processing logic handle out-of-order records?

АрхитектураArchitecture

Архитектура пакетной обработки имеет следующие логические компоненты, показанные на схеме выше.A batch processing architecture has the following logical components, shown in the diagram above.

Хранилище данных.Data storage. Обычно это распределенное хранилище файлов, которое может служить репозиторием для значительных объемов больших файлов в различных форматах.Typically a distributed file store that can serve as a repository for high volumes of large files in various formats. Зачастую этот тип хранилища часто называют Data Lake.Generically, this kind of store is often referred to as a data lake.

Пакетная обработка.Batch processing. Так как наборы данных очень велики, часто в решении обрабатываются длительные пакетные задания. Для них выполняется фильтрация, статистическая обработка и другие процессы подготовки данных к анализу.The high-volume nature of big data often means that solutions must process data files using long-running batch jobs to filter, aggregate, and otherwise prepare the data for analysis. Обычно в эти задания входит чтение исходных файлов, их обработка и запись выходных данных в новые файлы.Usually these jobs involve reading source files, processing them, and writing the output to new files.

Хранилище аналитических данных.Analytical data store. Многие решения по обработке больших данных спроектированы так, чтобы подготавливать данные к анализу и предоставлять их в структурированном формате для запросов через средства аналитики.Many big data solutions are designed to prepare data for analysis and then serve the processed data in a structured format that can be queried using analytical tools.

Анализ и создание отчетов.Analysis and reporting. Большинство решений по обработке больших данных предназначены для анализа и составления отчетов, что позволяет получить важную информацию.The goal of most big data solutions is to provide insights into the data through analysis and reporting.

Оркестрация.Orchestration. При пакетной обработке обычно требуется выполнить оркестрацию для переноса или копирования данных в хранилище, самой обработки, хранения аналитических данных и создания отчетов.With batch processing, typically some orchestration is required to migrate or copy the data into your data storage, batch processing, analytical data store, and reporting layers.

Выбор технологийTechnology choices

Мы рекомендуем применять следующие технологии для пакетной обработки данных в Azure.The following technologies are recommended choices for batch processing solutions in Azure.

Хранилище данныхData storage

- Контейнеры больших двоичных объектов хранилища Azure.Azure Storage Blob Containers. Многие существующие бизнес-процессы Azure уже используют хранилище больших двоичных объектов Azure, что делает это хорошим выбором для хранилища больших данных.Many existing Azure business processes already use Azure blob storage, making this a good choice for a big data store.

- Azure Data Lake StoreAzure Data Lake Store. Azure Data Lake Store предлагает практически неограниченное хранилище для файлов любого размера и широкие возможности обеспечения безопасности, что удобно для хранения чрезвычайно крупных решений обработки больших данных, для которых требуется централизованное хранилище содержимого в гетерогенных форматах.Azure Data Lake Store offers virtually unlimited storage for any size of file, and extensive security options, making it a good choice for extremely large-scale big data solutions that require a centralized store for data in heterogeneous formats.

Дополнительные сведения см. в статье о хранилище данных.For more information, see Data storage.

Пакетная обработкаBatch processing

- U-SQL.U-SQL. Это язык обработки запросов, используемый в Azure Data Lake Analytics.U-SQL is the query processing language used by Azure Data Lake Analytics. Он сочетает декларативный характер SQL с процедурной расширяемостью C# и обеспечивает эффективную обработку данных в значительном масштабе за счет параллелизма.It combines the declarative nature of SQL with the procedural extensibility of C#, and takes advantage of parallelism to enable efficient processing of data at massive scale.

- Hive.Hive. Это SQL-подобный язык, который поддерживается в большинстве дистрибутивов Hadoop, включая HDInsight.Hive is a SQL-like language that is supported in most Hadoop distributions, including HDInsight. Он может использоваться для обработки данных из любого хранилища, совместимого с HDFS, включая хранилище BLOB-объектов Azure и Azure Data Lake Store.It can be used to process data from any HDFS-compatible store, including Azure blob storage and Azure Data Lake Store.

- Pig.Pig. Это декларативный язык обработки больших данных, используемый во многих дистрибутивах Hadoop, включая HDInsight.Pig is a declarative big data processing language used in many Hadoop distributions, including HDInsight. Он особенно удобен для обработки данных, которые не структурированы или структурированы частично.It is particularly useful for processing data that is unstructured or semi-structured.

- Spark.Spark. Платформа Spark поддерживает программы пакетной обработки, написанные на разных языках, включая Java, Scala и Python.The Spark engine supports batch processing programs written in a range of languages, including Java, Scala, and Python. Spark использует распределенную архитектуру для параллельной обработки данных в нескольких рабочих узлах.Spark uses a distributed architecture to process data in parallel across multiple worker nodes.

Дополнительные сведения см. в статье Выбор технологии пакетной обработки в Azure.For more information, see Batch processing.

Хранилище аналитических данныхAnalytical data store

- Azure синапсе Analytics.Azure Synapse Analytics. Azure синапсе — это управляемая служба на основе технологий баз данных SQL Server и оптимизированная для поддержки крупномасштабных рабочих нагрузок хранилищ данных.Azure Synapse is a managed service based on SQL Server database technologies and optimized to support large-scale data warehousing workloads.

- Spark SQL.Spark SQL. Spark SQL представляет собой API на базе Spark, позволяющий создавать блоки данных и таблицы, к которым можно обращаться через запросы с синтаксисом SQL.Spark SQL is an API built on Spark that supports the creation of dataframes and tables that can be queried using SQL syntax.

- HBase.HBase. Это хранилище NoSQL с малой задержкой, которое позволяет выполнять высокопроизводительные, гибкие запросы к структурированным и частично структурированным данным.HBase is a low-latency NoSQL store that offers a high-performance, flexible option for querying structured and semi-structured data.

- Hive.Hive. Помимо полезных возможностей для пакетной обработки, Hive предлагает архитектуру базы данных, концептуально похожую на структуру типичной системы управления реляционной базой данных.In addition to being useful for batch processing, Hive offers a database architecture that is conceptually similar to that of a typical relational database management system. Благодаря усовершенствованиям производительности запросов Hive за счет таких инноваций, как обработчик Tez и инициатива Stinger, таблицы Hive можно эффективно использовать в качестве источников для аналитических запросов в некоторых сценариях.Improvements in Hive query performance through innovations like the Tez engine and Stinger initiative mean that Hive tables can be used effectively as sources for analytical queries in some scenarios.

Дополнительные сведения см. в статье о хранилище аналитических данных.For more information, see Analytical data stores.

Аналитика и отчетностьAnalytics and reporting

- Службы Azure Analysis Services.Azure Analysis Services. Многие решения для обработки больших данных имитируют традиционные корпоративные архитектуры бизнес-аналитики, включая централизованную модель данных оперативной аналитической обработки (OLAP) (часто называется кубом), в которой отчеты, панели мониторинга и интерактивные «срезы и кости» анализ может основываться на.Many big data solutions emulate traditional enterprise business intelligence architectures by including a centralized online analytical processing (OLAP) data model (often referred to as a cube) on which reports, dashboards, and interactive «slice and dice» analysis can be based. Службы Azure Analysis Services поддерживают создание табличных моделей для этих целей.Azure Analysis Services supports the creation of tabular models to meet this need.

- Power BI.Power BI. Power BI позволяет аналитикам данных создавать интерактивные визуализации на основе моделей данных в модели OLAP или непосредственно из хранилища аналитических данных.Power BI enables data analysts to create interactive data visualizations based on data models in an OLAP model or directly from an analytical data store.

- Microsoft Excel.Microsoft Excel. Это одно из наиболее широко используемых программных приложений в мире, которое предлагает множество возможностей для анализа и визуализации данных.Microsoft Excel is one of the most widely used software applications in the world, and offers a wealth of data analysis and visualization capabilities. Аналитики данных могут использовать Excel для создания моделей данных документов из хранилищ аналитических данных или для извлечения данных из моделей данных OLAP в интерактивные сводные таблицы и диаграммы.Data analysts can use Excel to build document data models from analytical data stores, or to retrieve data from OLAP data models into interactive PivotTables and charts.

Дополнительные сведения см. в статье об аналитике и отчетности.For more information, see Analytics and reporting.

ОркестрацияOrchestration

- Фабрика данных Azure.Azure Data Factory. Конвейеры фабрики данных Azure можно использовать для определения последовательности действий, запланированных для повторяющихся временных окон.Azure Data Factory pipelines can be used to define a sequence of activities, scheduled for recurring temporal windows. Эти действия могут инициировать операции копирования данных, а также задания Hive, Pig, MapReduce или Spark в кластерах HDInsight по запросу. Задания U-SQL в Azure Date Lake Analytics; и хранимые процедуры в Azure синапсе или базе данных SQL Azure.These activities can initiate data copy operations as well as Hive, Pig, MapReduce, or Spark jobs in on-demand HDInsight clusters; U-SQL jobs in Azure Date Lake Analytics; and stored procedures in Azure Synapse or Azure SQL Database.

- Oozie и Sqoop.Oozie and Sqoop. Oozie — это механизм автоматизации заданий для экосистемы Apache Hadoop. Он может использоваться для инициирования операций копирования данных, а также заданий Hive, Pig и MapReduce для обработки данных и заданий Sqoop для копирования данных между HDFS и базами данных SQL.Oozie is a job automation engine for the Apache Hadoop ecosystem and can be used to initiate data copy operations as well as Hive, Pig, and MapReduce jobs to process data and Sqoop jobs to copy data between HDFS and SQL databases.

Дополнительные сведения см. в статье Choosing a data pipeline orchestration technology in Azure (Выбор технологии оркестрации конвейера данных в Azure).For more information, see Pipeline orchestration

docs.microsoft.com

Пакетная обработка — это… Что такое Пакетная обработка?

Пакетная обработка

Поскольку составление расписаний машинного времени — долгая и утомительная процедура, нет ничего удивительного в том, что у пользователей ЭВМ появилась идея: а что, если всю организационную работу по составлению и контролю расписания работы пользователей на ЭВМ поручить самой вычислительной машине? По заданию, которое предназначено для компьютерной обработки, в ЭВМ вводятся конкретная программа и исходные данные. К этой информации добавляются специальные сообщения, в которых указывается, насколько срочной считается данная работа и сколько примерно она потребует машинного времени.

Все эти сведения собираются в каком-то одном месте, после чего по соответствующим признакам задается очередность заданий, и они начинают выполняться одно за другим. Данная система называется системой пакетной обработки заданий.

В системах, реализующих пакетную обработку информации, очередность выполнения заданий определяет операционная система компьютера (ОС). Определение очередности выполнения заданий, готовых к обработке, является функцией автоматического планировщика заданий в ОС. При планировании очередности предпочтение отдается заданиям с оговоренной высокой степенью срочности либо таким, которые по предварительным оценкам потребуют малого времени на обработку. Задания менее срочные, а также такие, которые требуют большего времени на обработку, откладываются. Однако для тех заданий, которые стоят в очереди уже давно, степень срочности автоматически повышается.

В отношении степени срочности или предварительной оценки времени, необходимого для выполнения конкретного задания, трудно каждый раз определять объективные критерии. Обычно поступающие на ЭВМ задания ранжируются (располагаются в возрастающие или убывающие по важности ряды) с помощью пяти градаций: <экспресс>, <срочно>, <безотлагательно>, <с обычной скоростью> и <с малой скоростью>. Плата за пользование машинным временем повышается со степенью приоритетности. Степень приоритетности, обозначенная <с малой скоростью>, означает, что задание можно пускать, когда очереди вообще нет и компьютер простаивает. Задания с самым низким уровнем приоритетности называются фоновыми заданиями.

Если говорить о предварительной оценке времени, необходимого для выполнения задания, то нередко бывает, что программа не укладывается в отведенное для нее время и задание снимается со счета. Обычно предполагаемое для решения время берут с запасом, и если его не хватило, задание все равно снимают по лимиту времени. Бывает, что уже через секунду ясно, что задача не будет решена в отведенное ей время, но, как и в случае останова машины Тьюринга, операционная система данную ситуацию оценить не сможет.

В системе с пакетной обработкой хорошо работать, если задания велики. Тогда коэффициент использования ЭВМ будет высоким. Такой метод практикуется в вычислительных центрах университетов и других высших учебных заведений. Там компьютеры работают круглосуточно, и если в очередях наступает перерыв, в систему вводятся фоновые задания.

Фоновые задания можно всегда прервать, сбросить промежуточные данные на внешний накопитель, a потом в удобное время запустить со средины счета. К категории фоновых заданий относятся программы диагностики работоспособности компьютерной системы или развлекательные программы, например вычисляющие число л с точностью в несколько тысяч десятичных знаков.

Недостаток систем с пакетной обработкой заданий состоит в том, что от момента постановки задания на очередь до получения готовых результатов счета проходит значительное время. Данная ситуация подобна работе почты или почтового ящика. Время, которое проходит от ввода задания в машину до выдачи на руки пользователю готового результата счета, либо время от получения этого результата до постановки на очередь следующего задания на эту же тему называется временем обращения. Для пакетного режима работы ЭВМ время обращения заданий может составлять от нескольких часов до нескольких дней.

dic.academic.ru

Пакетная обработка изображений.

Сегодня мы рассмотрим способ обработать большое количество изображений, затратив на это чуть больше времени, чем на обработку одного.

Как часто мы сталкиваемся с тем, что нам нужно обработать большое количество изображений под один шаблон? Гораздо чаще, чем нам кажется: выложить изображения одинакового размера на веб-сайт, расставить копирайт, выровнять баланс белого на фотографиях с одинаковым освещением и так далее. Делать всё это в ручную — довольно, продолжительный и утомительный процесс. Пакетная обработка изображений позволит вам сэкономить несколько часов времени, которое вы могли провести у экранов своих мониторов, повторяя одни и те же действия.

Шаг 1

Лучше создать на компьютере две папки. Одну назвать «Оригиналы» (из личного опыта посоветую сделать её копию — на всякий случай), вторую — «Результаты». В папку «Оригиналы» помещаем все наши фотографии, которые нужно обработать. Если вам требуется вставить фотографию в рамку или поставить копирайт, и важно, какой ориентации фотография (горизонтальная или вертикальная), то вновь разбиваем на две папки: в одну помещаем вертикальные фотографии, в другую горизонтальные. Плюс — первым делом задаём одинаковое разрешение для всех изображений (в случае с рамкой — равное её разрешению).

Шаг 2

Открываем в Photoshop любое изображение из папки «Оригиналы» и записываем для него Action. Для этого в окне «Операции»/»Аction« (иконка располагается рядом с «Историей», либо можете перейти из вкладки «История») сначала создаём новую папку для «Аction» (нажимаем на пиктограмму с изображением папки):

Далее создаем новый Аction (нажимаем на соответствующую пиктограмму):

Обозначение: Синий — создать новую операцию/create new action. Зеленый — воспроизвести действия, для открытого изображения. Красный — индикатор, при нажатии на который начинается запись, и он загорается красным. Черный — остановка записи.

Сразу после создания Action начинается запись всех действий, которые вы выполняете с открытым изображением, при этом индикатор записи горит красным. Чтобы остановить запись, нужно нажать на пиктограмму «Стоп» (выделена черным кружком).

Шаг 3

Обрабатываем изображение в зависимости от потребностей (изменение разрешения, цветокорекция, наложение фильтров). После всей нужной обработки сохраняем его в папку «Результаты» с помощью кнопки «Сохранить как» и нажимаем на «Стоп», чтобы остановить запись Action. После этого лучше удалить изображение из папки «Результаты», чтобы не запутаться.

Внимание! Ни в коем случае нельзя выделять какие-то отдельные части изображения и обрабатывать их! В этом случае на всех изображениях выделенная область будет обработана так, как вы это сделали с первым изображением.

Примерно так у вас должно получиться в итоге. В случае чего — любое действие вы можете удалить, просто перетащив его в корзину.

Шаг 4

Теперь нужно использовать Action для всех фотографий в папке «Оригиналы». Для этого заходим в меню Файл — Автоматизация — Пакетная обработка (File — Automate — Batch). Выбираем нужные папки и подходящие для вас настройки, нажимаем «Ок» и ждём, когда Photoshop обработает все изображения за вас.

P.S. Не забывайте, что возможности компьютера не безграничны, и если предстоит обработать большее количество фотографий, то лучше разбить их на две части (по нашим наблюдениям — так получится быстрее), и, поскольку большая нагрузка падает на оперативную память вашего компьютера, то для ускорения процесса ускорения (извините за каламбур) стоит закрыть все программы, помимо, собственнно, Photoshop.

P.P.S. Надеюсь, что этот урок сэкономит для вас много времени, всего доброго и удачных снимков!

rosphoto.com

Пакетная обработка фотографий

Зачастую нам приходится работать с большим количеством фотографий. Обрабатывать 300-500 фото за раз очень трудно и затратно по времени. Благодаря небольшому фотошоп уроку по пакетной обработке фотографий, вы научитесь за раз делать несколько действий над изображениями, что в разы сократит время на работу.

Рассмотрим урок на примере такого понятия как превью. Оно крайне важно для любого фотографа. Вы, может быть, сейчас скажете, что только увеличив изображение можно осознать его качество и мастерство съемки, но как показывает практика, даже самые хорошие фотографии редко размещаются в исходном размере. Скорее всего, так в рамках превью они и останутся. Тогда крайне важно, чтобы, несмотря на маленький размер, пользователь ощутил качество фото.

Главное в обработке фотографий небольших размеров – это резкость, особенно, если вы сильно уменьшили исходный размер изображения. Помимо изменения размера, при создании превью, обязательно увеличение резкости.

Если вам предстоит обработать несколько сотен фотографий (пакетная обработка), то наиболее целесообразным вариантом будет прибегнуть к помощи экшенов в фотошопе. В этом случае вам понадобится лишь один раз записать ход действий, и все, дальше программа сделает все за вас.

Наш экшен можно будет применять к фотографиям любого размера и тематики. Основные действия, которые нам требуются от экшена – это изменить размер фотографии, увеличить резкость и затем сохранить в нужном формате. Для этого нам для начала необходимо изучить команду Изменить размерность, она находится во вкладке Файл — Автоматизация.

В отличие просто от команды «Изменить размер», которая меняет размер изображения вне зависимости от того, изначально фотография была горизонтальная или же вертикальная, Изменить размерность распознает вид фотографии и соответственно приводит его к нужному виду.

Для того, чтобы наглядно представить в чем заключается работа команды, приведу пример. Представим, что через «Изменить размер» мы устанавливаем параметры 400px, в итоге все горизонтальные фотографии будут обработаны правильно, но вот вертикальные станут намного больше, так как у них 400px должна быть не ширина, а длина.

Через Изменить размерность мы просто ставим две нужные цифры и программа сама распознает, какое число касается длины, а какое – ширины.

Теперь перейдем к инструкции по пакетной обработке фотографии

Шаг 1

Для начала следует открыть любую фотографию. Над ней мы проведем ряд операций, которые запишем в экшен.

Шаг 2

Начинаем записывать экшен. Для этого откройте палитру Операции, создайте или выберите папку в которой он будет храниться, нажмите маленькую кнопочку внизу палитры Создать новую операцию, присвойте имя. Можете узнать более подробную информацию о том, как создавать экшены в фотошопе. Запись началась!

Внимание! Все следующие действия уже записываются в экшен.

Шаг 3

Необходимо конвертировать фотографию в формат sRGB (только этот стандарт правильно отображается всеми браузерами, на любых устройствах). Для записи действия необходимо нажать Редактировать — Изменить профиль. Если все исходники уже сохранены в нужном формате, то этот шаг можно исключить.

Шаг 4

В параметре Изменить размерность ставим значение 700px. Конечно, вы можете поставить любую цифру, но как показываем практика – это идеальный размер для превью.

Шаг 5

Теперь собственно главное – резкость. Чтобы оптимально увеличить резкость, лучше всего воспользоваться фильтром. Итак, переходим в раздел Фильтры — Резкость — Умная резкость. Установите оптимальные параметры.

Шаг 6

Остался последний шаг – сохранение изображения. Далее предстоит указать качество фотографии. Для интернет-сайтов оптимальным параметром будет 9-10.

Шаг 7

Напоследок закрываем фотографию, если не хотите в итоге получить 300 открытых вкладок.

Шаг 8

Нажимаем Стоп. Все! Наш универсальный экшен готов.

Есть одна вещь, с помощью которой обработка фотографий для интернета становится еще проще и удобнее. Это Droplet. Благодаря чему можно создать файл, который будет запускать работу всего экшена.

Как создать Droplet

Он создается из уже записанного экшена.

Шаг 1

Заходим в Файл — Автоматизация — Создать дроплет

Шаг 2

Следует настроить параметры:

- Выбрать папку, где хранятся фото;

- Выбрать уже записанный экшен;

- Выбрать папку, куда следует сохранять полученные фотографии.

После нажатия на кнопку ОК, в папке, которую вы указали, появится дроплет в виде синий стрелочки. Вам достаточно перенести ваши фотографии на эту стрелочку, как тут же к ним будут применены все предустановленные настройки.

Экономьте свое время и пользуетесь пакетной обработкой фотографий!

Заметили ошибку в тексте — выделите ее и нажмите Ctrl + Enter. Спасибо!

psand.ru

Actions в Photoshop. Пакетная обработка фотографий для интернета

В одной из прошлых статей я писал о том, что такое actions в Photoshop и как с ними работать.

В этой статье я расскажу о простом и очень удобном способе обработки большого количества фотографий для публикации в интернете. С помощью actions в Photoshop мы сделаем экшен, который будет сам изменять размер, увеличивать резкость и сохранять превью ваших фотографий для интернета.

Превью фотографии — это очень важная вещь, так как именно по превью зрители будут оценивать качество ваших работ. Многие фотографы не придают превью большого значения, мол, «фулсайз надо смотреть, чтобы оценить качество фотографии». Они, безусловно, правы. Но на практике 99% людей увидят только превью ваших фотографий — в блоге, фотогалерее или на страничке Вконтакте.

Именно поэтому превью ваших фотографий должны выглядеть максимально качественно. И прежде всего это касается резкости изображения. При ресайзе фотографии резкость неизбежно ухудшается, и на превью необходимо увеличивать резкость. Если вы этого не сделаете, зритель будет уверен, что на вашей фотографии проблемы с резкостью. А хорошая, «звенящая» резкость на превью сразу делает кадр более привлекательным.

Просто сравните эти две фотографии, превью с увеличенной резкостью смотрится значительно лучше.

Но обрабатывать каждую фотографию вручную крайне утомительно. Если надо подготовить 3-5 фотографий, это, безусловно, не займет много времени. А если речь идет о 20-30 кадрах или 300-500? В статье о съемке репортажа я писал, насколько важно предоставить заказчику вместе с фулсайзами и превью всех фотографий. И без экшенов тут никак не обойтись.

Одно из самых главных преимуществ работы с actions в том, что надо потратить немного времени и один раз написать экшн, а дальше вы сможете сэкономить массу времени, используя его в обработке.

Именно такой action мы и напишем сегодня. Он универсален, и вы сможете использовать его с любыми своими фотографиями.

Наша задача — сделать action, который будет сам ресайзить фотографии до нужного размера, увеличивать резкость и сохранять фотографии в нужном нам качестве.

Написание подобного экшена невозможно без одной очень удобной функции в Photoshop — Fit Image.

Fit Image позволяет подогнать изображение под заданный размер. Обычно для изменения размера фотографии используется Image Size, но у него есть один серьезный недостаток. В Image Size нельзя просто указать значение длинной стороны изображения, можно только выставить значение высоты и ширины изображения. Из-за этого возникает проблема с вертикально и горизонтально ориентированными фотографиями.

Допустим, мы поставим ширину изображения 700 px. С горизонтальными кадрами все будет в порядке, но вертикальные кадры станут значительно больше горизонтальных. Потому что у них длинная сторона — вертикальная (то есть высота), а размер 700 px установлен для ширины изображения.

Частично эту проблему решает процентное изменение размера изображения, например, сделать размер превью 20% от размера оригинала. Но если оригиналы фотографий различаются в размере, то и превью их будут разными. Для пакетной обработки фотографий этот способ не подходит.

Нам нужен универсальный экшен, который будет одинаково работать со всеми фотографиями. Именно поэтому нужно использовать функцию Fit Image.

Вам достаточно выставить в значении высоты и ширины одно и тоже число, и Photoshop будет сам определять длинную сторону изображения и изменять ее размер.

Создаем новый экшен и начинаем запись:

1. Открываем любую фотографию в Photoshop и над ней будем проводить манипуляции, которые запишутся в action.

2. Теперь конвертируем в sRGB — Edit=>Convert To Profile, на тот случай, если вы работаете с Adobe RGB или ProPhoto RGB. Дело в том, что sRGB — это стандартный цветовой профиль, который правильно понимают все интернет-браузеры. Adobe RGB и ProRGB не поддерживаются большинством распространенных браузеров. Если вы работаете только с sRGB, это действие можно не вписывать в экшн.

3. Применяем Fit Image со значением 700 px. На мой взгляд, 700 px — это оптимальный размер превью фотографии. Хотя вы можете выставить там любое другое значение, конечно.

4. Займемся увеличением резкости. Открываем Filter=>Sharpen=>Smart Sharpen. В зависимости от ваших личных предпочтений устанавливаем настройки резкости. Я, как правило, делаю такие настройки:

5. Наше превью готово, осталось только сохранить фотографию — File=>Save As.

В этом окне важно обратить внимание на строку Embed Color Profile. Поставив галочку рядом с этим пунктом, вы прикрепляете к файлу ICC профиль.

Затем откроется окно настроек — для публикации в интернете качества 9-10 будет более чем достаточно.

6. Закрываем фотографию — это действие тоже должно быть записано в экшене.

Вот и все, нажимаем Stop и наш action готов.

О том, как применить экшен сразу на большое количество фотографий, можно прочитать в нашей статье об основах работы с actions в Photoshop.

Но есть одна вещь, с помощью которой обработка фотографий для интернета становится еще проще и удобнее. Это Droplet в Photoshop.

Создаем Droplet

Droplet — это очень удобная функция для работы с экшенами.

Суть ее работы в том, что вы можете создать файл, запускающий работу нужного вам экшена.

Создав Droplet, вам будет достаточно перетащить на его икону фотографии, и автоматически запустится Photoshop, а выбранные фотографии будут обработаны экшеном.

Сделать Droplet из экшена очень просто:

1. Заходим в File=>Automate=>Create Droplet

2. Настраиваем параметры Droplet’а

- Выбираем, куда сохранить файл дроплета

- Какой сет и экшн использовать

- Куда сохранять получившиеся фотографии

Все остальные настройки практически аналогичны настройкам окна Batch при работе с actions.

Теперь у вас есть файл-дроплет экшена, и вы можете просто перетаскивать в него фотографии, которые хотите обработать для интернета.

fototips.ru

Пакетная обработка в Photoshop — логотип на фотографиях ⋆ Vendigo.ru

Крылья… ноги… Главное хвост!

(из одного мультфильма)

Из этого урока вы узнаете:

Как работать с экшенами, основы автоматизации и пакетной обработки в Photoshop.

Как поставить свой логотип на фотографию одной кнопкой.

Как добавлять свой логотип к фотографиям при экспорте из Lightroom.

Выкладывая фотографии в интернет, многие добавляют на снимки свою подпись или логотип. В некоторой степени это позволяет защитить свои авторские права, хотя если логотип не перекрывает фотографию от края до края, то удалить его не составит труда.

Добавить любой логотип в Photoshop довольно просто. Но делать это все время вручную вам быстро надоест. Поэтому, лучше автоматизировать процесс, например с помощью экшена. Но для начала рассмотрим добавление подписи.

Ставим подпись

Я добавляю на фотографии надпись в виде текста «Vendigo ©» выполненную определенным шрифтом. Вот так:

Для создания подобной надписи выберете инструмент T, щелкните по фотографии и введите текст. (поскольку символ копирайта довольно сложно набрать с клавиатуры, я заранее копирую надпись в буфер обмена). Цвет текста белый.

После этого, я добавляю тень к тексту, чтобы он был виден даже на белом фоне, а саму надпись делаю полупрозрачной. Для этого в панели слоев дважды щелкните по слою с текстом и в открывшемся окне Layer Style настройте тень следующим образом:

После чего в панели слоев снизьте значение Fill до 20 — 50%.

При необходимости, измените размер надписи и расположите ее так как вам нравится, я сдвигаю ее в правый нижний угол.

Все это довольно просто, но есть один момент, который важен при создании экшена — это положение логотипа. Фотографии могут быть разного размера, и разной ориентации: горизонтальной или вертикальной. Мне нужно, чтобы логотип всегда позиционировался относительно правого нижнего угла.

Для этого прибегнем к следующему: На палитре слоев выделим оба слоя, для чего по очереди щелкнем по ним, удерживая нажатой клавишу Shift. Затем выберем инструмент «стрелка» Move Tool (V). И щелкнем по кнопкам выравнивания относительно нижней и правой границы:

При этом наш логотип сдвинется в правый нижний угол. После чего выберем на палитре слоев только надпись и помощью курсорных клавиш немного отодвинем ее от краев, (клавиша Shift в сочетании со стрелками сдвигает объект сразу на 10 пикселей).

Расположив логотип в углу с помощью этой процедуры, мы можем быть уверены, что он будет на месте независимо от размеров и ориентации фотографии. Теперь можно приступать к созданию экшена.

Actions в Photoshop

Экшены в Photoshop довольно простое и действенное средство автоматизации работы. Выглядит это так: у нас есть ряд операций, которые мы периодически выполняем. Чтобы их автоматизировать мы создаем экшен. Во время создания экшена мы выполняем запись всех действий, которые нам нужно автоматизировать. После того как запись закончена мы сможем повторять эти действия, просто запуская наш экшен! Это действительно просто.

Перед созданием любого экшена лучше порепетировать, чтобы в момент записи не делать лишних шагов. Так же лучше записывать экшен в обстановке максимально приближенной к боевой. Т.е. если вы планируете добавлять логотип на фотографии размещаемые в интернете, откройте для этого фотографию уменьшенную для WEB.

Итак, придумав свою подпись, выбрав шрифт и размер текста. Определившись с его цветом, стилем слоя и расположением мы готовы к созданию экшена.

Для этого нам понадобится панель Actions, обычно она расположена рядом с Историей.

Внизу панели расположен ряд кнопок: Стоп, Запись, Воспроизведение, Создание папки, Создание экшена (выделено). Рекомендую вам сразу создать новую папку чтобы не потерять свои экшены среди десятка стандартных.

Для создания экшена нажмите кнопку Create new action, и задайте его название в появившемся окне, например «Copyright».

В строке Set: выбирается папка. Так же можно выбрать цвет и горячую клавишу, F2 — F12 с учетом Shift и Ctrl. После чего жмите кнопку Record.

С этого момента началась запись ваших действий, о чем свидетельствует активированная кнопка Begin recording.

Теперь размещаем логотип на фотографии, все как описывалось выше:

Отступление: Если ваш логотип графический, а не текстовый то выполните команду File – Place и вставьте ваш логотип из файла.

- Выбираем инструмент Текст (T).

- Вставляем подготовленную надпись из буфера обмена Ctrl+V.

- Выделяем оба имеющихся слоя в панели Layers.

- С помощью кнопок инструмента Move Tool (V) сдвигаем надпись в нужный нам угол.

- Выбираем слой с текстом. Курсорными клавишами и клавишей Shift задаем нужный отступ от краев.

- Два раза щелкаем по слою с текстом и в окне Layer Style задаем тень и любые понравившиеся нам эффекты.

- Уменьшаем прозрачность слоя с помощью параметра Fill.

После того как рисование логотипа завершено, жмем кнопку Stop – экшен готов!

Теперь нужно протестировать его. Для этого удалите слой с текстом, выберете только что созданный экшен в панели Actions и нажмите кнопку Play. Если все сделано правильно, то через секунду вы увидите свой логотип в углу фотографии!

Начало положено. Теперь вы умеете создавать экшены, и можете автоматизировать повторяющиеся операции. А их у фотографа может накопиться немало. С экшенами будет меньше рутины, а значит больше удовольствия от любимого занятия и больше времени для креатива.

Actions — параметры

Выше я описал как создается экшен в Photoshop. Для краткости я рассказал лишь основные моменты необходимые для его создания. Сейчас я более подробно опишу этот инструмент.

Щелкните два раза по экшену, и перед вами откроется окно его настроек:

Удобно, после создания экшена (не всегда это получается с первого раза) назначить ему горячую клавишу. Выберите в соответствующем окне клавишу от F2 до F12 (можно задействовать Shift и Ctrl). После этого создание подписи выполняется нажатием одной кнопки, что неизменно радует.

Развернув созданный экшен, вы увидите все команды, которые в нем записаны:

Команды можно перемещать (перетаскиванием), удалять и копировать. Их можно выключать, снимая галочку (отмечено 1). Или указать Photoshop остановится, и показать окно настроек (отмечено 2). С помощью таких остановок, можно сделать гибкий экшен. В определенные моменты Photoshop будет останавливаться, и ожидать ваших действий.

Так же экшен можно дописывать с помощью кнопки запись, что бывает удобно, если вы немного ошиблись, нет нужды переписывать весь экшен с самого начала.

Пакетная обработка в Photoshop

С помощью экшенов можно эффективно обрабатывать множество снимков. Допустим нам нужно разместить логотип на всех фотографиях из некоторой папки. Для этого в меню Photoshop выполните команду: File – Scripts – Image Processor…

Откроется окно пакетной обработки:

1. В первой секции укажите папку с файлами, которые нужно обработать. При необходимости обработать файлы в подпапках поставьте галочку Include All sud-folders.

2. Во второй секции укажите папку, в которую будут сохраняться обработанные файлы. Опция Keep folder structure перенесет структуру вложенных папок.

Опция Save in same location сохранит файлы в исходной папке, но не перезапишет их, файлы будут лежать во вложенной папке [JPEG] (PSD или TIFF).

3. В третьей секции выберете формат файла, в который будет сохранено изображение, а так же его настройки. При желании можно указать размеры, в которые будет вписан файл.

4. В последней секции подключается необходимый экшен. Собственно та обработка которая и будет применяться ко всем файлам.

По нажатию кнопки Run Photoshop начнет обрабатывать файлы, а вы можете откинуться на спинку кресла и насладится заслуженным отдыхом!

Подключаем экшен к экспорту Lightroom

Еще одной возможностью автоматизировать работу в Фотошопе является создание дроплета, или иными словами исполняемого файла. Дроплеты создаются из экшенов, с помощью команды File – Automate – Create Droplet. Использовать дроплет очень просто, нужно просто перетащить файлы на него, тем самым запустив их обработку, или же перетащить на него целую папку. Дроплеты удобны своей мобильностью, их можно пересылать своим друзьям или переносить с компьютера на компьютер. Конечно, сам дроплет не может обработать файлы, для этого он запускает Photoshop, а если его нет на компьютере то он и не сработает.

Одним из преимуществ дроплета, является то, что его можно подключить к экспорту в Lightroom. Таким образом, экспортируя фотографии из Lightroom, можно автоматически добавлять к ним свой логотип.

Создание дроплета

Перед созданием дроплета нужно немного модифицировать наш экшен. Добавим в него команды, слить слои, сохранить и закрыть документ.

- Скопируйте созданный экшен, перетащив его мышкой на кнопку Create new action. Переименуйте его например в Copyright Droplet.

- Откройте подходящую по размерам фотографию в Photoshop.

- Выполните экшен.

- Раскройте его команды, перейдите в конец и нажмите «запись».

- Объедините слои (Ctrl+Shift+E).

- Выполните команду Сохранить как (Ctrl+Shift+S). И сохраните снимок в JPEG с нужным вам уровнем сжатия. Куда вы сохраните файл, и как его назовете в этом случае не важно.

- Закройте документ.

- Нажмите Стоп. Новый экшен готов.

Как вы уже поняли, новый экшен, сохраняет файл и выгружает его из Photoshop. Для пакетной обработки можно записывать команду Сохранить или Сохранить как. Разница между ними в том, что в команде Save As сохраняются настройки формата файла, например качество сжатия JPEG (команда Save сохраняет параметры, которые были у файла при открытии).

Есть важный момент, в команде Save As так же сохраняется путь к файлу и его имя. Таким образом если этот экшен применить к пакету файлов, все они будут сохранены в одном месте под одним и тем же именем! Для того чтобы обойти этот момент в окне Create Droplet есть опция Override Action “Save As” Commands. Эта опция убирает из команды Сохранить Как имя файла и путь к файлу, но сохраняет настройки формата файла.

Теперь преобразуем экшен в дроплет: File – Automate – Create Droplet.

С помощью кнопки Choose укажите где и под каким именем создать файл.

В секции Play выберете подготовленный экшен, обычно последний подставляется автоматически.

В секции Destination выберете Save and Close, и поставьте галочку Override Action “Save As” Commands.

Жмем Ок – получаем дроплет.

Примечание: Как ни странно команда Save and Close или Folder не сохраняет файлы если в экшене не было команды Сохранить или Сохранить как. То же самое относится к окну File – Automate – Batch. Довольно запутанная система с сохранением файлов с обязательной записью этих команд в экшен, поэтому я предпочитаю для пакетной обработки пользоваться инструментом Image Processor.

Далее идем в Lightroom, открываем экспорт, и подключаем наш дроплет вот здесь:

(Подробнее про экспорт в Lightroom читайте в этом уроке)

После чего сохраняем настройки экспорта как пресет, и пользуемся в свое удовольствие!

Урок получился длинный, но как мудро сказано в одном мультфильме «лучше день потерять, потом за час долететь»!

Всем спасибо за внимание 🙂

vendigo.ru

Пакетная обработка фотографий и автоматизация действий в Photoshop

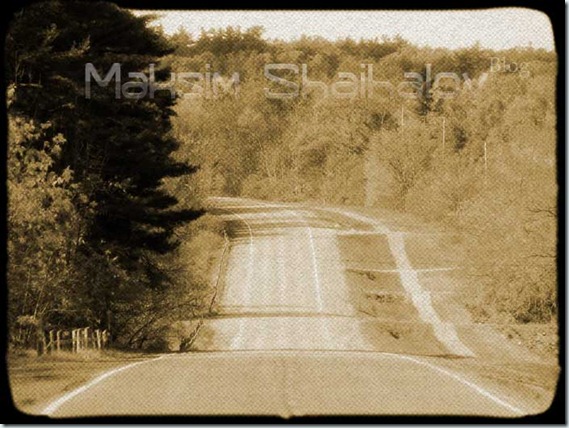

Привет всем! На этот раз я покажу вам некоторые из основ автоматизации в Photoshop, а также их практическое применение. Мы создадим сложное действие, на основе его построим Droplet и проведем операцию пакетного редактирования с целой папкой.

Привет всем! На этот раз я покажу вам некоторые из основ автоматизации в Photoshop, а также их практическое применение. Мы создадим сложное действие, на основе его построим Droplet и проведем операцию пакетного редактирования с целой папкой.

Часть I — Как создать Action в Photoshop

Шаг 1 — Приступим!

Не каждый пользователь фотошопа — дизайнер. Есть множество людей, которым необходимы графические инструменты, которые могут сделать их жизнь легче. Если вы фотограф или веб-мастер, этот урок поможет вам.

Во-первых, поместите все фотографии, которые вы хотите обработать в отдельную папку. Затем откройте любую из этих картинок.

Мы будем использовать ее для создания Actions в фотошопе.

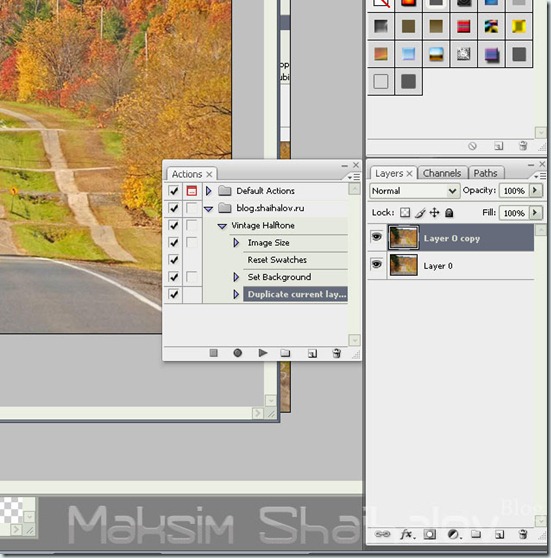

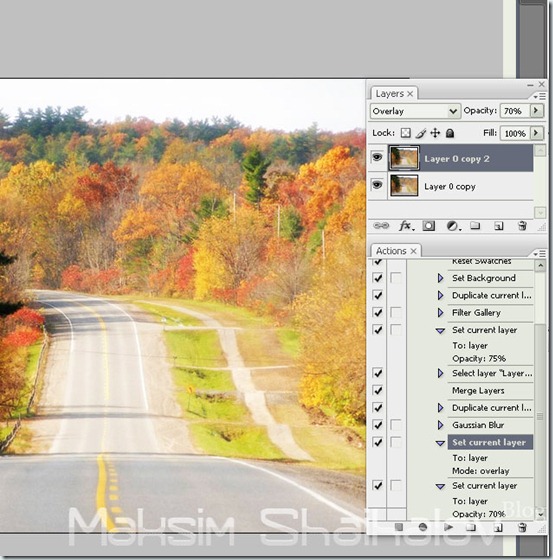

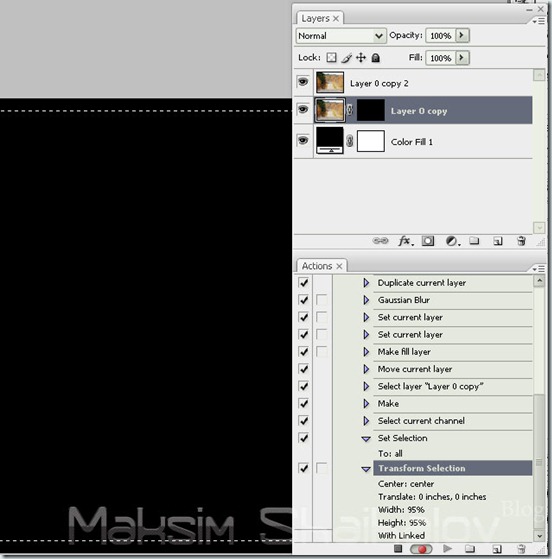

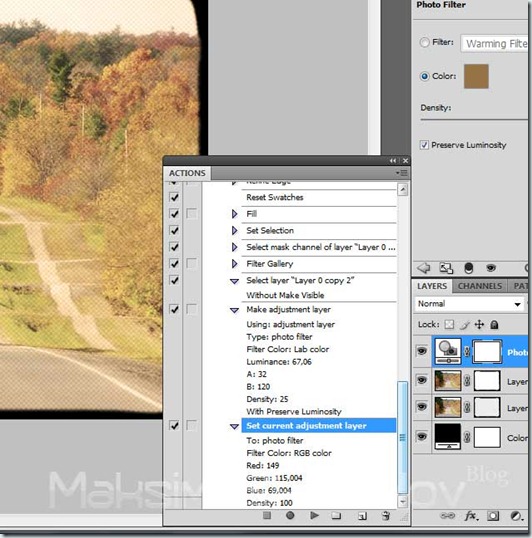

Шаг 2 — Настройка экшенов в фотошопе

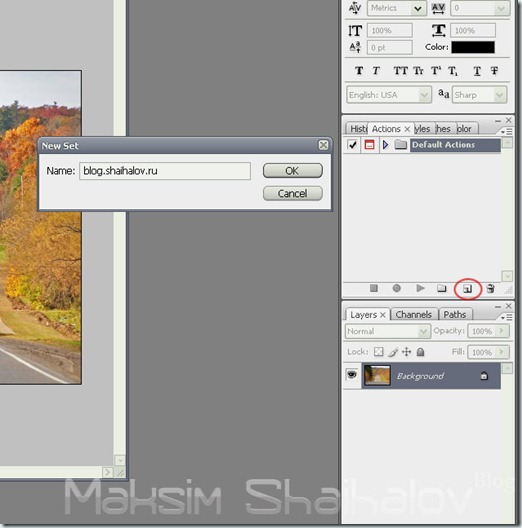

Для начала откройте окно Actions (выберите Window> Actions или нажмите Alt + F9). Создадим новую группу Action.

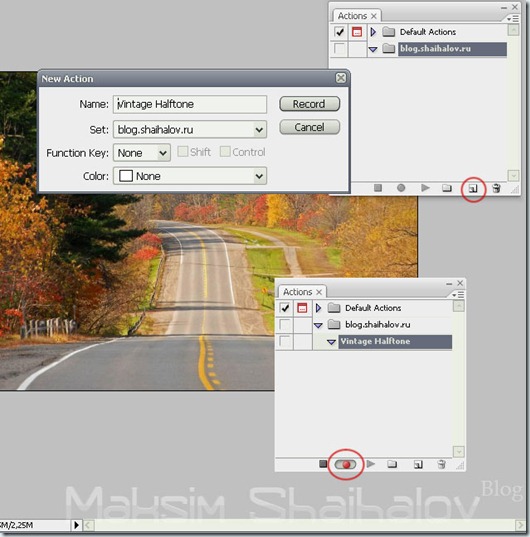

После создания группы — создадим конкретное действие. Щелкните на листочек внизу панели Action. Назовем новое действие «Vintage Halftone».

После создания обратите внимание на три маленькие иконки: стоп, запись и воспроизведение. Для следующего шага необходимо, чтобы была активна иконка записи.

Шаг 3 — Изменение размера изображения при помощи Image size

Построим действие. Я объясню, как и что нужно делать. Будьте внимательны и следуйте инструкциям.

После того как вы открыли свою фотографию и иконка записи активна, приступайте к записи шагов.

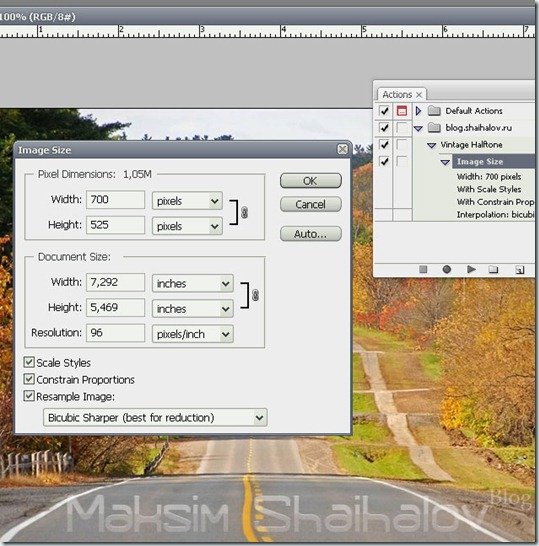

Первым шагом будет изменение размера изображения. Поскольку я собираюсь использовать фотографии в веб-галерее необходимо уменьшить их. Для этого я выбираю Image> Image Size и установливаю значение ширины в 700px и ставлю галочку, чтобы сохранить пропорции. Кроме того, необходим флажок Resample Image и выбрать Bicubic Shaper (best for reduction).

В блоге есть отдельная статья о том, как уменьшить фотографию в Фотошопе.

Не изменяйте размер изображения с помощью других методов (например Free Transform). Потому как на вертикальных изображениях такое не пройдет.

Нажмите ОК и перейдите к следующему шагу.

Шаг 4 — Копируем изображение.

Теперь, хорошо бы сбросить цвета которыми мы рисуем. Для этого можно просто использовать D на клавиатуре.

Не меняйте цвета с помощь выбора цвета или пипетки.

Затем дважды щелкните на слое «Background» в палитре слоев. И нажмите «OK»

Перетащите слой на значок «Great new layer», будет создана копия слоя.

Убедитесь, что «Layer 0 copy» выбран и перейдите к следующему шагу.

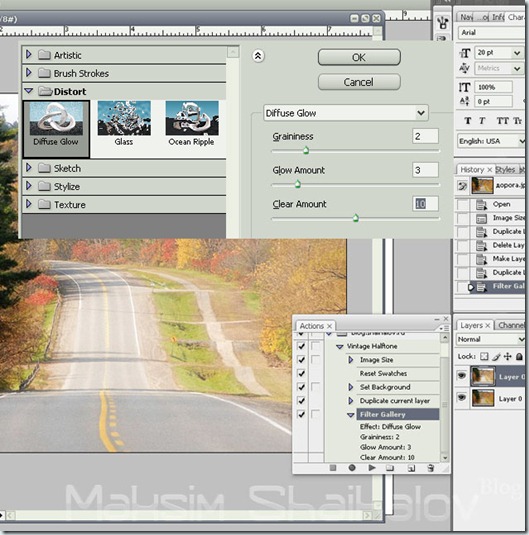

Шаг 5 — Добавляем Diffuse Glow

Слой «Layer 0 copy» выбран и мы собираемся добавить фильтр Diffuse Glow к нему. Это увеличит освещение и придаст драматический вид изображению. Зайдите в Filter> Filter Gallery и выберите Distort> Diffuse Glow. Установите значения, как показано ниже, и нажмите кнопку ОК.

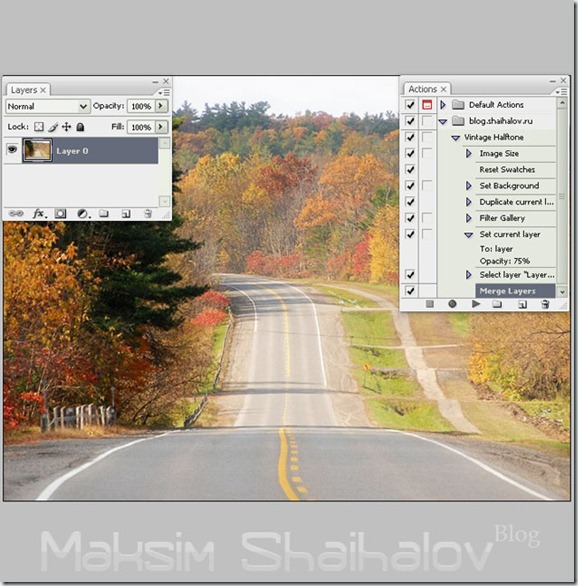

Шаг 6 — Изменение Opacity и Merge Layers

Немного уменьшим непрозрачность слоя «Layer 0 copy» (до 75% например).

Не используйте ползунок, чтобы изменить значение непрозрачности, потому как Photoshop будет записывать каждый шаг на каждый процент (100, 99, 98, 97 … 75) а этого не хотим.

Далее, Shift + клик на миниатюре слоя «Layer 0», щелкаем правой кнопкой мыши и выбираем пункт Merge Layers.

Итоговый слоя должен называться «Layer 0 copy».

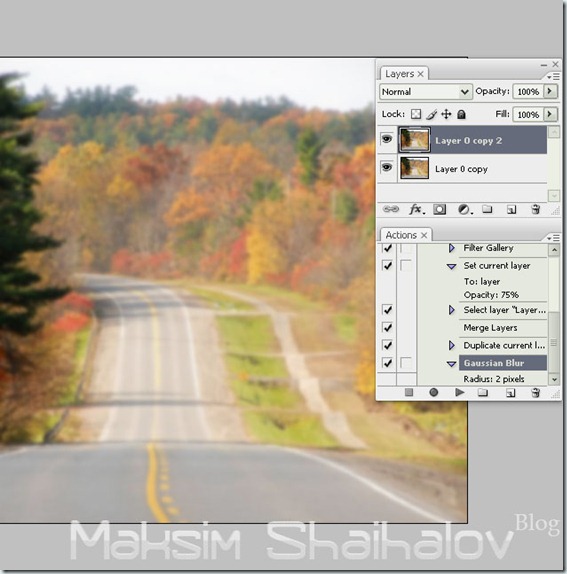

Шаг 7 — Gaussian Blur Filter

Дублируйте слой «Layer 0 copy», как было описанно выше.

Убедитесь, что слой «Layer 0 copy 2» выбран и перейдите Filter> Blur> Gaussian Blur, установите радиус 2 пикселя и нажмите ОК.

Шаг 8 — Измененяем Blending Mode копии.

Измените Blending Mode слоя «Layer 0 copy 2» на Overlay.

Если вы хотите попробовать разные режимы смешивания нажмите на кнопку Stop в окне Actions и эксперементируйте! Затем нажмите Record, и выберите желаемый режим смешивания.

Наконец, установите значение непрозрачности на 70%.

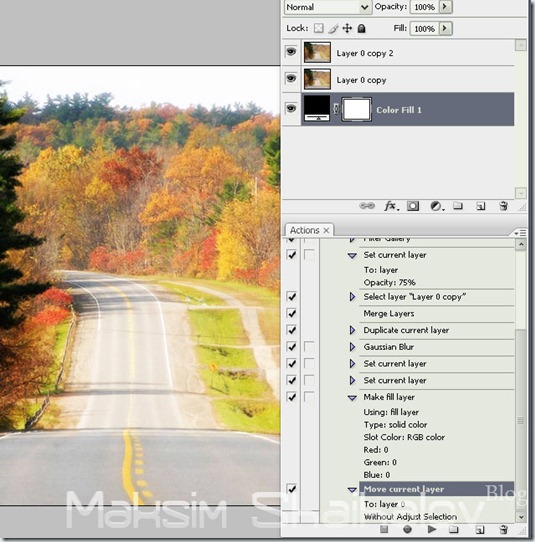

Шаг 9 — Создаем заливку слоя

Теперь, давайте добавим черный фон к нашей работе.

Для этого перейдите Layer >New Fill Layer > Solid Color, нажмите ОК и выберите цвет # 000000.

Переместите слой «Color Fill 1» в самый низ.

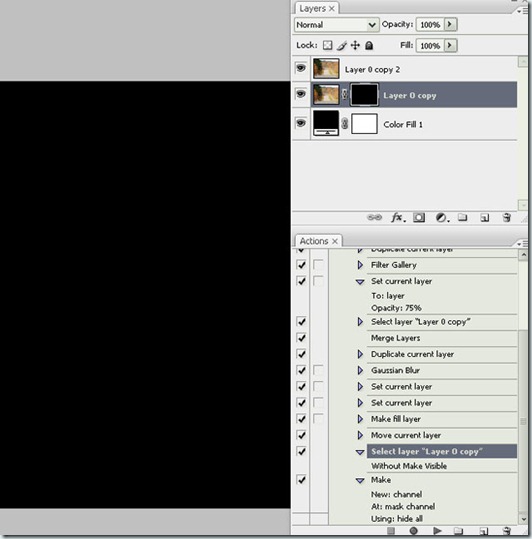

Шаг 10 — Добавим маску слоя

Нажмите на миниатюру «Layer 0 copy» и выберите Layer> Layer Mask> Hide All.

Шаг 11 — Выберите маску слоя

Теперь мы собираемся создать случайную обводку на наших фотографиях.

После создания маски слоя, вы должны нажать на ее миниатюре, а затем выделить все, нажав Ctrl+ A на клавиатуре.

Это важный шаг, если вы не нажмете на миниатюре маски слоя, то в конце получите уродливый результат =)

Кроме того, когда Вы выбираете все, вы не можете использовать Marquee Tool и сделать произвольный выбор. Если вы это сделаете, Photoshop будет хранить координаты как точные цифры только для конкретной фотографии, и это не сработает на любой другой.

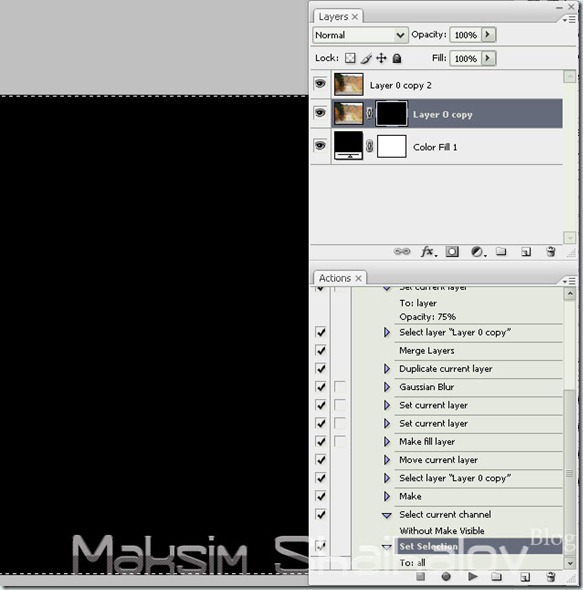

Шаг 12 — Преобразование выбора

Теперь выберите Marquee Tool в палитре инструментов. Правой кнопкой щелкаем на выделении, и выбираем опцию Transform Selection.

Обратите внимание на верхнюю панель, там есть два значения W и H (это ширина и высота, там должно быть 100%). Нажмите на маленькую цепочку в середине и измените значения до 95%. Таким образом, вы сократите выделение на 5%. Нажимаем на галочку и применяем преобразование.

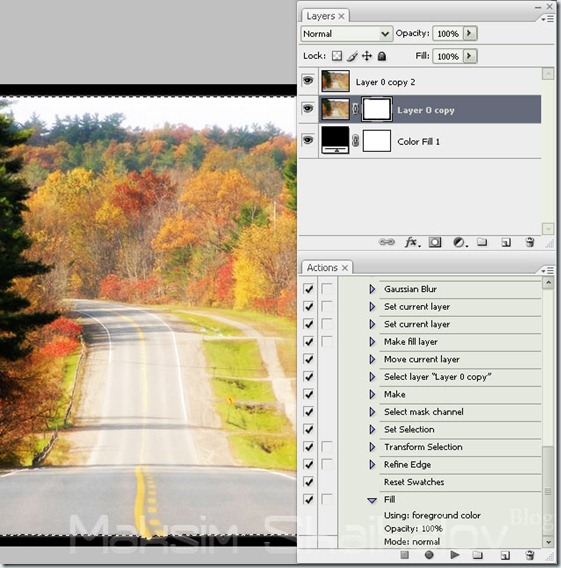

Шаг 13 — Создание произвольной границы

Изменим выделение произвольно.

Убедитесь, что выбрана маска «Layer 0 copy».

Затем зайдите в Select> Refine edge, и установите значение как на скриншоте и нажмите кнопку ОК.

У вас должно получится что-то вроде этого.

Если вы работаете с другим размером изображения, вы должны немного поиграть со значениями Refine edge.

Шаг 14 — Заливаем выделение

Теперь заполните выделение белым цветом.

Сбросьте цвета клавишей D. Затем выберите инструмент Marquee в палитре инструментов, щелкните правой кнопкой мыши и выберите Fill… В диалоговом окне установите настройки как на скриншоте.

Наконец, нажмите Ctrl + D, чтобы снять выделение.

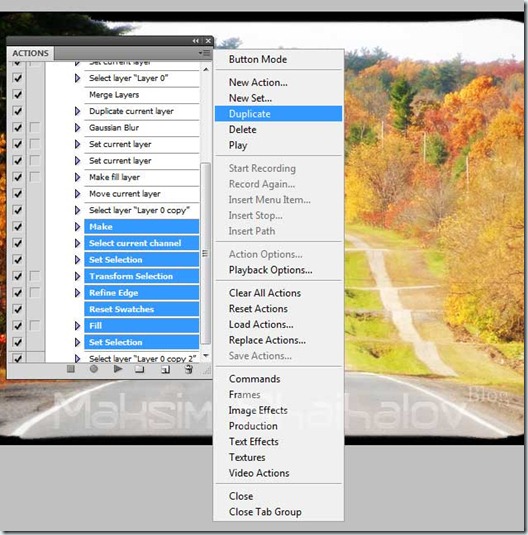

Шаг 15 — Копируем действия

Теперь давайте повторим процесс создания произвольной границы (шаги с 10 по 14), но на этот раз на слой «Layer 0 copy 2».

Эти действия можно просто дублировать в окне «Actions».

Чтобы скопировать шаги, сначала выберите «Layer 0 copy 2». Остановите запись.

Затем выберите (в окне Actions) все этапы процесса по созданию границ, т.е. от «Set Selection» до шага перед Select «Layer 0 copy 2».

Щелкните на кнопку справа и выбирите Duplicate. Они скопируются.

Теперь просто перетащите выбранные действия ниже шага «Select ‘Layer 0 copy 2’». Запустите воспроизведение выбранных фрагментов.

Наконец, щелкните на последнем шаге в окне «Actions» и запустите запись.

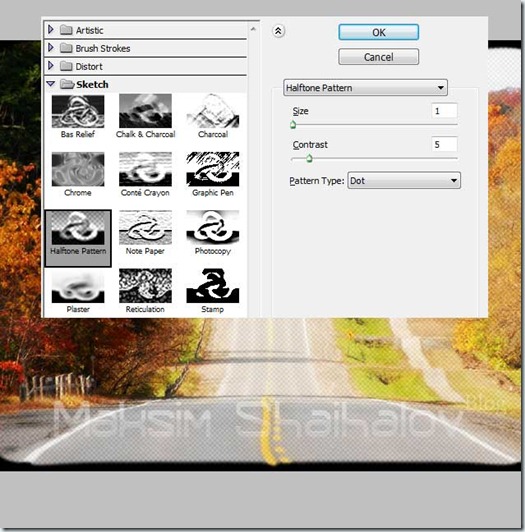

Шаг 16 — Обработка с Halftone Pattern

Затем щелкните на миниатюре маски слоя «Layer 0 copy.» Далее, войдите в Filter> Filter Gallery, и перейдите к Sketch> Halftone Pattern и установите значения, приведенные ниже, а затем нажмите кнопку ОК.

Шаг 17 — Добавиим Photo Filter

Выберите «Layer 0 copy 2» в палитре слоев, а затем идем в Create New Fill или Adjustment Layer> Photo Filter, выбираем цвет (# 957345) и установим Density 100%. Нажимаем ОК.

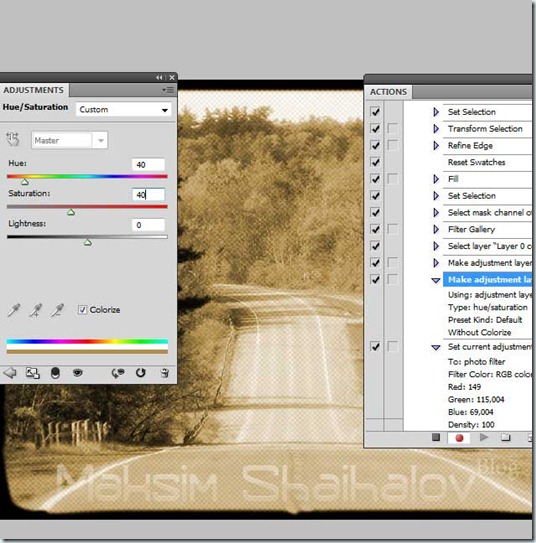

Шаг 18 — Hue / Saturation

После, идем Adjustment Layer > Hue Saturation, выберите значения как на скриншоте и нажмите кнопку ОК.

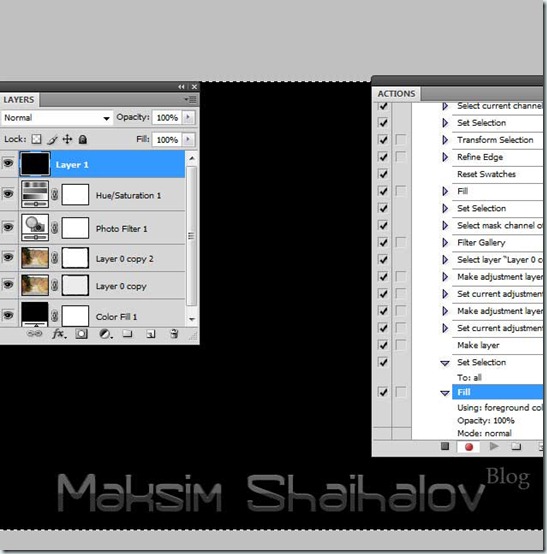

Шаг 19 — Заливаем новый слой

В палитре слоев создаем новый слой, и расположим его выше всех остальных. Оставим ему имя «Layer 1.» Затем Ctrl + A (выделить все) затем выберите инструмент Marquee, щелкните правой кнопкой мыши и выберем «Fill…» используем цвет переднего плана. Все должно залиться черным цветом.

Шаг 20

Теперь добавьте к «Layer 1» эффект Pattern Overlay. Я использую «Gray Granite» из пакета Grayscale Paper.

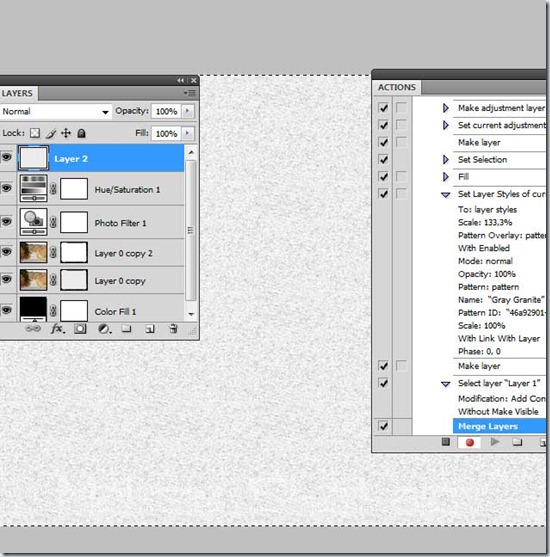

Шаг 21 — Растризуем эффекта слоя

Создаем еще один слой.

Затем Shift+клик на слое «Layer 1» в палитре слоев, чтобы выделить оба слоя. И жмем Ctrl + E, чтобы объединить их.

Шаг 22 — Изменения режима наложения и непрозрачности

Теперь изменим режим смешивания «Layer 2» на Multiply и непрозрачность на 75%.

Шаг 23 — Flatten image

В палитре слоев выбираем все слои. Щелкаем правой кнопкой и выбираем Flatten image. Наконец, в окне Actions можно нажать Стоп.

Вот и все! Теперь мы можем применять эти действия к любым фотографиям.

Конец Части I – проверяем!

Теперь пришло время проверить, правильно ли ваши действия работают на другой фотографии. Для этого открываем фотографию находим наше действие (Vintage Halftone) и нажимаем кнопку воспроизведения.

Прежде чем двигаться вперед, неплохо бы сохранить само действие.

Для этого выберите набор действий «blog.shaihalov.ru» а окне «Actions», а затем передите к дополнительным параметрам (значок в правой верхней части) и выберите Save Actions… Введите имя для своего действия и сохраняйте его где угодно.

Теперь можно перейти к пакетному редактированию.

Часть II — Пакетная обработка фотографий в фотошопе

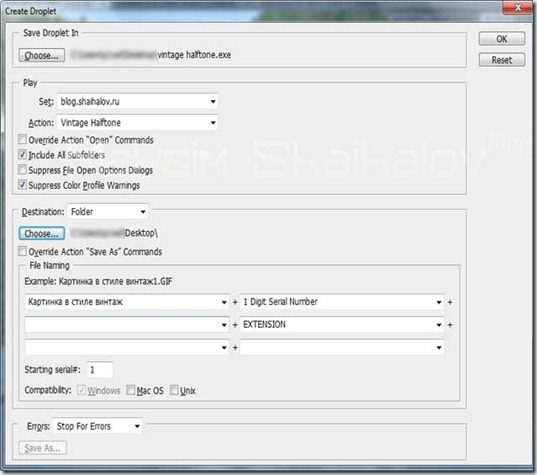

Шаг 1 — Создание Droplet для пакетной обработки

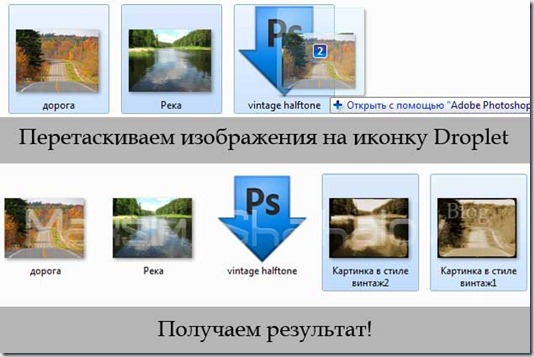

Дроплеты применяют actions к одному или нескольким изображениям или даже к папке, если вы перетащите их на иконку капли.

Вы можете сохранить droplet где угодно и использовать его столько раз, сколько необходимо. Чтобы создать droplet, перейдите в меню File > Automate > Create droplet… Там вы можете посмотреть всё множество вариантов.

Сначала выберите исходную папку фотографий и сохраните droplet там. Для опции Play выберите набор «blog.shaihalov.ru» и действие Vintage halftone. Для папки назначения я выберу другую папку.

Кроме того, можно настроить имя результирующего изображения путем добавления пользовательского текста, последовательности чисел, расширения и щелкнуть максимальную совместимость. После того как Вы настроили droplet, нажмите кнопку ОК.

Шаг 2 — Работаем с droplet.

Теперь откройте вашу папку с изображениями. Выберите и перетащите нужные изображения на иконку дроплета.Вы увидите что Photoshop автоматом отредактирует выбранные изображения и сохранит их в указаную папку.

Заключение

Автоматизация действий в Photoshop подчас экономит очень много времени. Ей должны уметь пользоваться будущие дизайнеры, веб-мастера и фотографы.

Советую попробовать эти приемы со своей фотографией =)

blog.shaihalov.ru